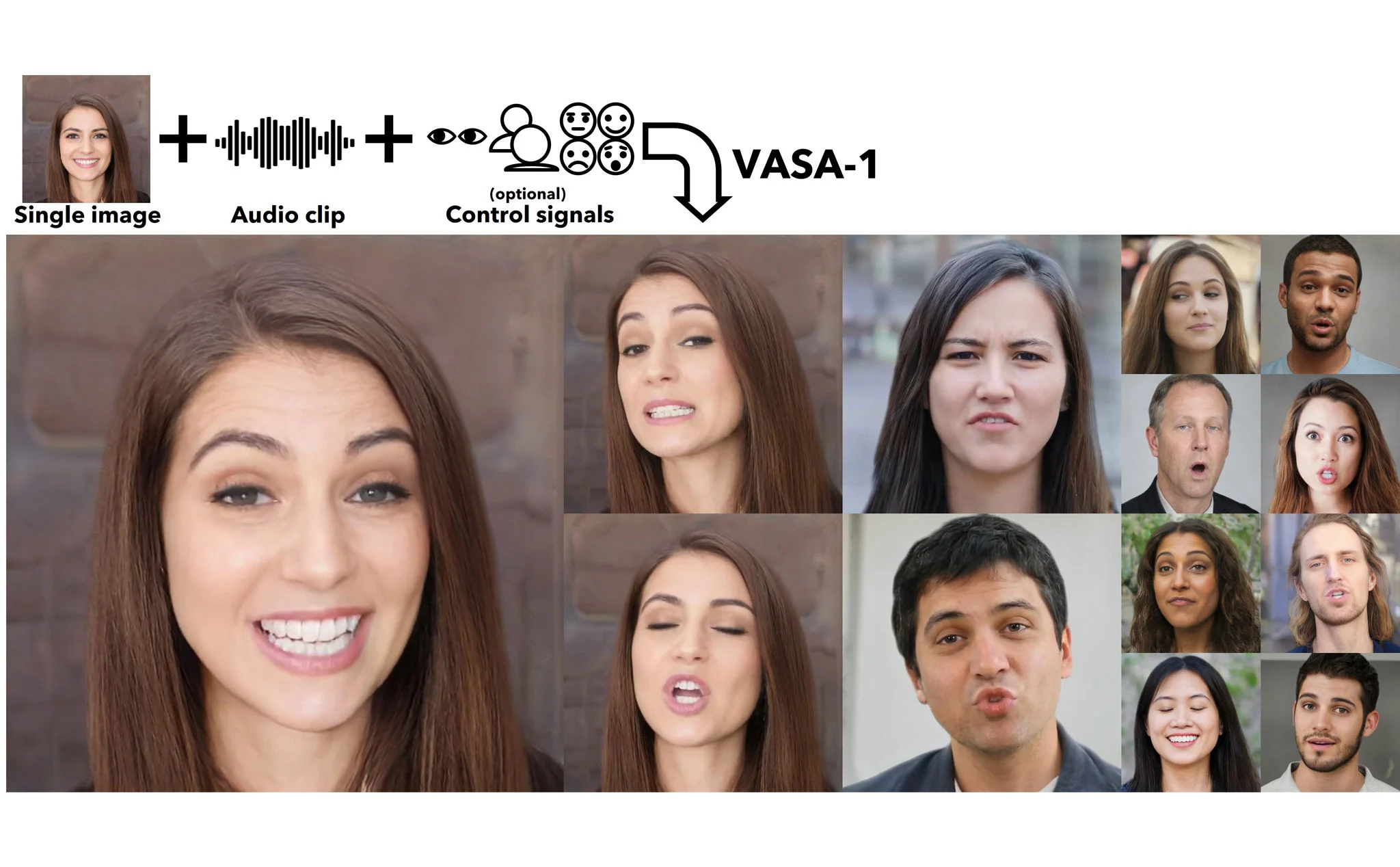

Từ một tấm hình chân dung + một đoạn ghi âm giọng nói, model VASA-1 của nhóm nghiên cứu Microsoft châu Á có thể tạo ra một đoạn video lip sync với đầy đủ biểu cảm gương mặt, góc mặt, chuyển động đầu, mắt, miệng, các cơ trên mặt,… Tất cả đều được AI tạo ra real time.

Theo nhóm nghiên cứu, VASA là một framework không chỉ có khả năng tạo ra chuyển động của môi, miệng một cách đồng bộ với âm thanh mà nó còn tạo ra nhiều biến đổi khác trên gương mặt để cố “giống thật” nhất. Họ cho biết gen model đã xử lý toàn bộ các biến đổi trên gương mặt và cả các góc mặt trong không gian latent để tạo ra kết quả cuối cùng là một video 512 x 512, 40 fps với độ trễ của tiếng và hình là không đáng kể.

Về hiệu quả, VASA có thể chạy với phần cứng desktop 1 con GPU 4090, đoạn video tạo ra ở chế độ phát trực tiếp chỉ có độ trễ 170ms khi play.

Hiện nhóm vẫn chưa có kế hoạch phát hành API hay sản phẩm cụ thể của VASA. Bên dưới đây là một số thí dụ, họ tạo ra những chân dung người bên dưới bằng StyleGAN2 hoặc DALL.E-3. Mời anh em xem qua.

Đầu tiên là một số video với hình tĩnh + voice dài khoảng 1 phút

Thêm nhiều giọng nói hơn

Cùng một người nhưng nhiều góc mặt khác nhau, anh em để ý chuyển động liếc mắt, lấy hơi,…

Khoảng cách khác nhau

Cấc biểu cảm khác nhau khi nói của cùng 1 người

Video bên dưới biểu diễn khả năng tạo ra video trong không gian 3D

Theo https://tinhte.vn/

You need to login in order to like this post: click here

YOU MIGHT ALSO LIKE