Một vấn đề mà người dùng các hệ thống AI lớn như ChatGPT, Gemini hay Llama gặp phải là các AI này thường xuyên bị “ảo giác”. Trước đây, đã có báo cáo về việc các AI gây tổn hại danh tiếng trên diện rộng. Bất chấp những cảnh báo về việc phải tự xác minh thông tin thêm, vấn đề này vẫn còn bỏ ngỏ. Hơn nữa, làm thế nào chúng ta có thể giải quyết vấn đề này khi không thể truy ngược lại lỗi?

Vấn đề khó tránh khỏi là nếu AI bị “ảo giác” vẫn chưa được giải quyết, thì AI Agentic sẽ đáng tin cậy đến mức nào? Bởi vì AI Agentic được thiết kế cho các prompt quy mô lớn hơn, chẳng hạn như đặt phòng khách sạn, bán vé và quản lý tài chính. Nếu vấn đề AI bị “ảo giác”(AI Hallucination) vẫn chưa được giải quyết, thì sẽ kéo theo nhiều vấn đề hơn là bịa chuyện, trình bày sai sự thật, mà còn bao gồm cả các lỗi tài chính.

Các mô hình ngôn ngữ lớn (LLM) sử dụng kỹ thuật “Deep Learning” để thu thập lượng lớn dữ liệu và mô phỏng các dự đoán giống con người về nhiều tình huống khác nhau. Tuy nhiên, vấn đề là loại dữ liệu này có thể dễ dàng gây hiểu lầm cho người dùng, vì nó là một mô hình dự đoán chứ không phải là sự hiểu biết thực sự.

AI hiện đang bị chỉ trích vì mức tiêu thụ năng lượng quá mức và nguy cơ thông tin sai lệch. Ngay cả khi có sự can thiệp của con người vào việc đưa ra quyết định cuối cùng, vấn đề thông tin sai lệch vẫn chưa được giải quyết.

Các mô hình ngôn ngữ lớn (LLM) đòi hỏi dữ liệu đào tạo khổng lồ. Do đó, chúng đã bắt đầu sử dụng “dữ liệu tổng hợp”(Synthetic Data), tức là dữ liệu do chính AI tạo ra. Vấn đề là dữ liệu tổng hợp này có thể sao chép và tái tạo các lỗi hiện có, khiến các mô hình AI mới kế thừa những điểm yếu từ các mô hình cũ. Điều này dẫn đến chi phí sửa đổi mô hình sau khi đào tạo rất cao. Hơn nữa, việc phát hiện lỗi ngày càng khó khăn đối với các lập trình viên, vì quá trình tư duy của AI ngày càng phức tạp.

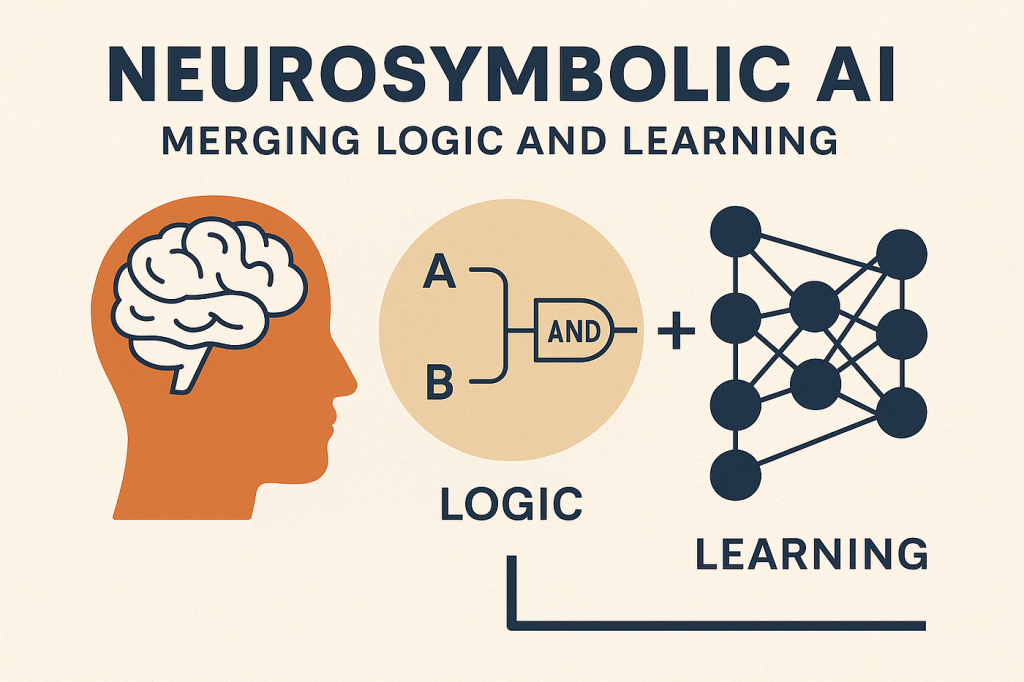

Một khái niệm mới mang tên “Neuro-symbolic AI” cố gắng kết hợp thế mạnh của hai loại AI:

Các quy tắc này có thể được đưa trực tiếp vào hệ thống AI, hoặc AI có thể học và trích xuất các quy tắc này từ các tập dữ liệu huấn luyện.

Ưu điểm của Neuro-symbolic AI

Hiện tại, Neuro-symbolic AI đang được sử dụng cho các nhiệm vụ chuyên biệt với các quy tắc rõ ràng, chẳng hạn như Google’s AlphaFold(dự đoán cấu trúc protein) và AlphaGeometry (giải các bài toán hình học). Đối với các ứng dụng AI tổng quát hơn, cần nghiên cứu thêm để rút ra các quy tắc chung tốt hơn.

Mặc dù chưa rõ các nhà phát triển LLM đang theo đuổi hướng này đến mức nào, nhưng ý tưởng này cho thấy rằng để AI tiếp tục phát triển, chúng ta cần các hệ thống có thể thích ứng với các tình huống mới với dữ liệu tối thiểu, có thể tự kiểm tra hiểu biết của mình, có thể thực hiện đa nhiệm và quan trọng là có thể tái sử dụng kiến thức để cải thiện hiệu suất và lập luận thuyết phục.

You need to login in order to like this post: click here

YOU MIGHT ALSO LIKE